- 1970sbedit

- 1980er JahreBearbeiten

- Menükosten und unvollkommener Wettbewerbbearbeiten

- Das Calvo-Modell für gestaffelte Verträge

- Koordinationsfehlerbearbeiten

- Arbeitsmarktversagen: Effizienzlöhne

- 1990er Jahre

- Die neue neoklassische Synthese

- Taylor-Regelbearbeiten

- Die neue keynesianische Phillips-Kurve

- Die Wissenschaft der Geldpolitik

- 2000Bearbeiten

- The introduction of imperfectly competitive labor marketsEdit

- Die Entwicklung komplexer DSGE-Modelle.Edit

- Sticky informationEdit

- 2010Bearbeiten

1970sbedit

Die erste Welle der New Keynesian Economics entwickelte sich in den späten 1970er Jahren. Das erste Modell der klebrigen Informationen wurde von Stanley Fischer in seinem Artikel von 1977, Langfristige Verträge, rationale Erwartungen und die optimale Geldmengenregel, entwickelt. Er nahm ein „gestaffeltes“ oder „überlappendes“ Vertragsmodell an. Angenommen, es gibt zwei Gewerkschaften in der Wirtschaft, die abwechselnd Löhne wählen. Wenn eine Gewerkschaft an der Reihe ist, wählt sie die Löhne, die sie für die nächsten zwei Perioden festlegt. Dies steht im Gegensatz zu John B. Taylors Modell, bei dem der Nominallohn über die Vertragslaufzeit konstant ist, wie es später in seinen beiden Artikeln entwickelt wurde, einer im Jahr 1979 „Gestaffelte Lohneinstellung in einem Makromodell“. und einer in 1980 „Aggregate Dynamics and Staggered Contracts“. Sowohl Taylor- als auch Fischer-Verträge teilen das Merkmal, dass nur die Gewerkschaften, die den Lohn in der aktuellen Periode festlegen, die neuesten Informationen verwenden: Die Löhne in der Hälfte der Wirtschaft spiegeln immer noch alte Informationen wider. Das Taylor-Modell hatte klebrige Nominallöhne zusätzlich zu den klebrigen Informationen: die Nominallöhne mussten über die gesamte Vertragsdauer (zwei Perioden) konstant sein. Diese frühen neukeynesianischen Theorien basierten auf der Grundidee, dass eine Währungsbehörde (Zentralbank) bei festen Nominallöhnen die Beschäftigungsquote kontrollieren kann. Da die Löhne nominal festgelegt sind, kann die Währungsbehörde den Reallohn (inflationsbereinigte Lohnwerte) durch Änderung der Geldmenge kontrollieren und somit die Beschäftigungsquote beeinflussen.

1980er JahreBearbeiten

Menükosten und unvollkommener Wettbewerbbearbeiten

In den 1980er Jahren wurde das Schlüsselkonzept der Verwendung von Menükosten im Rahmen eines unvollkommenen Wettbewerbs zur Erklärung der Preisbeständigkeit entwickelt. Das Konzept der Pauschalkosten (Menükosten) zur Änderung des Preises wurde ursprünglich von Sheshinski und Weiss (1977) in ihrem Artikel über die Auswirkungen der Inflation auf die Häufigkeit von Preisänderungen eingeführt. Die Idee, sie als allgemeine Theorie der nominalen Preisstarrheit anzuwenden, wurde 1985-6 von mehreren Ökonomen gleichzeitig vorgebracht. George Akerlof und Janet Yellen brachten die Idee vor, dass Unternehmen aufgrund begrenzter Rationalität ihren Preis nicht ändern wollen, es sei denn, der Nutzen ist mehr als ein kleiner Betrag. Diese begrenzte Rationalität führt zu einer Trägheit der Nominalpreise und Löhne, was dazu führen kann, dass die Produktion bei konstanten Nominalpreisen und Löhnen schwankt. Gregory Mankiw nahm die Menükosten-Idee auf und konzentrierte sich auf die Wohlfahrtseffekte von Produktionsänderungen, die sich aus klebrigen Preisen ergeben. Michael Parkin brachte auch die Idee vor. Obwohl sich der Ansatz zunächst hauptsächlich auf die Starrheit der Nominalpreise konzentrierte, wurde er von Olivier Blanchard und Nobuhiro Kiyotaki in ihrem einflussreichen Artikel Monopolistischer Wettbewerb und die Auswirkungen der Gesamtnachfrage auf Löhne und Preise ausgeweitet . Huw Dixon und Claus Hansen zeigten, dass selbst wenn diese Kosten auf einen kleinen Wirtschaftssektor angewendet würden, dies den Rest der Wirtschaft beeinflussen und dazu führen würde, dass die Preise in der übrigen Wirtschaft weniger auf Nachfrageänderungen reagieren.

Während einige Studien darauf hindeuteten, dass die Menükosten zu gering sind, um einen großen Gesamteinfluss zu haben, zeigten Laurence Ball und David Romer 1990, dass reale Rigiditäten mit nominalen Rigiditäten interagieren könnten, um ein signifikantes Ungleichgewicht zu erzeugen. Reale Rigiditäten treten immer dann auf, wenn ein Unternehmen seine realen Preise nur langsam an ein sich änderndes wirtschaftliches Umfeld anpasst. Zum Beispiel kann ein Unternehmen mit echten Rigiditäten konfrontiert sein, wenn es über Marktmacht verfügt oder wenn seine Kosten für Inputs und Löhne durch einen Vertrag gebunden sind. Ball und Romer argumentierten, dass reale Starrheiten auf dem Arbeitsmarkt die Kosten eines Unternehmens hoch halten, was dazu führt, dass Unternehmen zögern, die Preise zu senken und Einnahmen zu verlieren. Die Kosten, die durch reale Rigiditäten in Kombination mit den zusätzlichen Kosten für Preisänderungen entstehen, machen es weniger wahrscheinlich, dass das Unternehmen die Preise auf ein Marktclearing-Niveau senkt.

Selbst wenn die Preise vollkommen flexibel sind, kann ein unvollkommener Wettbewerb den Einfluss der Fiskalpolitik auf den Multiplikator beeinflussen. Huw Dixon und Gregory Mankiw entwickelten unabhängig voneinander einfache allgemeine Gleichgewichtsmodelle, die zeigen, dass der fiskalische Multiplikator mit dem Grad des unvollkommenen Wettbewerbs auf dem Output-Markt zunehmen könnte. Der Grund dafür ist, dass der unvollkommene Wettbewerb auf dem Produktionsmarkt dazu neigt, den Reallohn zu senken, was dazu führt, dass der Haushalt vom Konsum in die Freizeit wechselt. Wenn die Staatsausgaben erhöht werden, führt die entsprechende Erhöhung der Pauschalbesteuerung dazu, dass sowohl die Freizeit als auch der Konsum sinken (vorausgesetzt, beide sind ein normales Gut). Je größer der Grad des unvollkommenen Wettbewerbs auf dem Produktionsmarkt ist, desto niedriger ist der Reallohn und desto stärker fällt der Rückgang auf die Freizeit (d. H. Die Haushalte arbeiten mehr) und weniger auf den Konsum. Daher ist der fiskalische Multiplikator kleiner als eins, aber der Grad des unvollkommenen Wettbewerbs auf dem Output-Markt nimmt zu.

Das Calvo-Modell für gestaffelte Verträge

1983 schrieb Guillermo Calvo „Gestaffelte Preise in einem nutzenmaximierenden Rahmen“. Der ursprüngliche Artikel wurde in einem mathematischen Rahmen für kontinuierliche Zeit geschrieben, wird aber heutzutage hauptsächlich in seiner diskreten Zeitversion verwendet. Das Calvo-Modell ist die gebräuchlichste Methode zur Modellierung der nominalen Starrheit in neuen keynesianischen Modellen. Es besteht die Wahrscheinlichkeit, dass das Unternehmen seinen Preis in einem beliebigen Zeitraum h (die Hazard-Rate) oder äquivalent die Wahrscheinlichkeit (1-h) zurücksetzen kann, dass der Preis in diesem Zeitraum unverändert bleibt (die Überlebensrate). Die Wahrscheinlichkeit h wird in diesem Zusammenhang manchmal als „Calvo-Wahrscheinlichkeit“ bezeichnet. Im Calvo-Modell ist das entscheidende Merkmal, dass der Preissetzer nicht weiß, wie lange der Nominalpreis bestehen bleibt, im Gegensatz zum Taylor-Modell, bei dem die Vertragsdauer ex ante bekannt ist.

Koordinationsfehlerbearbeiten

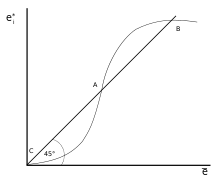

Koordinationsversagen war ein weiteres wichtiges neues keynesianisches Konzept, das als eine weitere mögliche Erklärung für Rezessionen und Arbeitslosigkeit entwickelt wurde. In Rezessionen kann eine Fabrik untätig bleiben, obwohl es Menschen gibt, die bereit sind, darin zu arbeiten, und Menschen, die bereit sind, ihre Produktion zu kaufen, wenn sie Arbeitsplätze hätten. In einem solchen Szenario scheinen wirtschaftliche Abschwünge das Ergebnis eines Koordinationsversagens zu sein: Die unsichtbare Hand kann den üblichen, optimalen Produktions- und Verbrauchsfluss nicht koordinieren. Russell Cooper und Andrew Johns 1988-Papier Coordinating Coordination Failures in Keynesian Models drückten eine allgemeine Form der Koordination als Modelle mit mehreren Gleichgewichten aus, bei denen Agenten koordinieren konnten, um jede ihrer jeweiligen Situationen zu verbessern (oder zumindest nicht zu schädigen). Cooper und John stützten ihre Arbeit auf frühere Modelle, darunter das Coconut-Modell von Peter Diamond aus dem Jahr 1982, das einen Fall von Koordinationsversagen mit Such- und Matching-Theorie demonstrierte. Im heutigen Modell produzieren Produzenten eher, wenn sie andere produzieren sehen. Die Zunahme möglicher Handelspartner erhöht die Wahrscheinlichkeit, dass ein bestimmter Produzent jemanden findet, mit dem er handeln kann. Wie in anderen Fällen von Koordinationsversagen weist das Diamond-Modell mehrere Gleichgewichte auf, und das Wohlergehen eines Agenten hängt von den Entscheidungen anderer ab. Das Diamond-Modell ist ein Beispiel für eine „Thick-Market-Externalität“, die dazu führt, dass Märkte besser funktionieren, wenn mehr Menschen und Unternehmen daran teilnehmen. Andere mögliche Quellen für Koordinationsversagen sind sich selbst erfüllende Prophezeiungen. Wenn ein Unternehmen einen Nachfragerückgang erwartet, könnte es die Einstellung einschränken. Ein Mangel an offenen Stellen könnte Arbeitnehmer beunruhigen, die dann ihren Konsum einschränken. Dieser Nachfragerückgang entspricht den Erwartungen des Unternehmens, ist jedoch ausschließlich auf das eigene Handeln zurückzuführen.

Arbeitsmarktversagen: Effizienzlöhne

Neue Keynesianer boten Erklärungen für das Versagen des Arbeitsmarktes, sich zu klären. Auf einem walrasischen Markt bieten arbeitslose Löhne, bis die Nachfrage nach Arbeitskräften das Angebot erfüllt. Wenn die Märkte Walrasian sind, würden die Reihen der Arbeitslosen auf Arbeitnehmer beschränkt sein, die zwischen Arbeitsplätzen wechseln, und auf Arbeitnehmer, die sich dafür entscheiden, nicht zu arbeiten, weil die Löhne zu niedrig sind, um sie anzuziehen. Sie entwickelten mehrere Theorien, die erklären, warum Märkte willige Arbeiter arbeitslos machen könnten. Die wichtigste dieser Theorien, neue Keynesianer war die Effizienzlohntheorie verwendet, um langfristige Auswirkungen der früheren Arbeitslosigkeit zu erklären, wo kurzfristige Erhöhungen der Arbeitslosigkeit dauerhaft werden und auf lange Sicht zu höheren Arbeitslosenquoten führen.

In Effizienzlohnmodellen werden Arbeitnehmer auf einem Niveau bezahlt, das die Produktivität maximiert, anstatt den Markt zu räumen. In Entwicklungsländern zahlen Unternehmen beispielsweise möglicherweise mehr als einen marktüblichen Satz, um sicherzustellen, dass sich ihre Arbeitnehmer genügend Nahrung leisten können, um produktiv zu sein. Unternehmen könnten auch höhere Löhne zahlen, um Loyalität und Moral zu erhöhen, was möglicherweise zu einer besseren Produktivität führt. Unternehmen können auch höhere Löhne zahlen als der Markt, um Druck zu vermeiden. Besonders einflussreich waren Shirking-Modelle.Carl Shapiro (Carl Shapiro) und Joseph Stiglitz (Joseph Stiglitz)’s 1984 Papiergleichgewichtsarbeitslosigkeit als eine Arbeitskraftdisziplin schuf ein Modell, wo Angestellte dazu neigen, Arbeit zu vermeiden, es sei denn, Firmen können Arbeitskraftanstrengung kontrollieren und nachlassende Angestellte mit der Arbeitslosigkeit bedrohen. Wenn die Wirtschaft vollbeschäftigt ist, wechselt ein entlassener Shirker einfach zu einem neuen Job. Einzelne Unternehmen zahlen ihren Arbeitnehmern eine Prämie über dem Marktzins, um sicherzustellen, dass ihre Arbeitnehmer lieber arbeiten und ihren derzeitigen Arbeitsplatz behalten, anstatt sich zu drücken und zu riskieren, zu einem neuen Arbeitsplatz wechseln zu müssen. Da jedes Unternehmen mehr als Marktclearing-Löhne zahlt, kann sich der aggregierte Arbeitsmarkt nicht klären. Dies schafft einen Pool von Arbeitslosen und erhöht die Kosten für die Entlassung. Arbeitnehmer riskieren nicht nur einen niedrigeren Lohn, sie riskieren auch, im Pool der Arbeitslosen stecken zu bleiben. Die Löhne über dem Marktclearing-Niveau zu halten, schafft einen ernsthaften Anreiz, sich zu drücken, was die Arbeitnehmer effizienter macht, obwohl einige willige Arbeitnehmer arbeitslos werden.

1990er Jahre

Die neue neoklassische Synthese

In den frühen 1990er Jahren begannen Ökonomen, die in den 1980er Jahren und früher entwickelten Elemente der neukeynesianischen Ökonomie mit der realen Konjunkturtheorie zu kombinieren. RBC-Modelle waren dynamisch, gingen aber von perfektem Wettbewerb aus; Neue keynesianische Modelle waren in erster Linie statisch, basierten aber auf unvollkommenem Wettbewerb. Die neue neoklassische Synthese verband im Wesentlichen die dynamischen Aspekte der RBC mit unvollkommenem Wettbewerb und nominalen Rigiditäten der neuen keynesianischen Modelle. Tack Yun war einer der ersten, der dies in einem Modell mit dem Calvo-Preismodell tat. Goodfriend und King schlugen eine Liste von vier Elementen vor, die für die neue Synthese von zentraler Bedeutung sind: intertemporale Optimierung, rationale Erwartungen, unvollkommener Wettbewerb und kostspielige Preisanpassung (Menükosten). Goodfriend und King finden auch, dass die Konsensmodelle bestimmte politische Implikationen haben: Während die Geldpolitik kurzfristig die reale Produktion beeinflussen kann, gibt es keinen langfristigen Kompromiss: Geld ist kurzfristig nicht neutral, aber langfristig. Inflation hat negative Wohlfahrtseffekte. Es ist wichtig, dass die Zentralbanken ihre Glaubwürdigkeit durch eine regelbasierte Politik wie Inflationsziele wahren.

Taylor-Regelbearbeiten

Im Jahr 1993 formulierte John B Taylor die Idee einer Taylor-Regel, die eine reduzierte Form der Annäherung der Reaktionsfähigkeit des Nominalzinssatzes, wie von der Zentralbank festgelegt, auf Änderungen der Inflation, der Produktion oder anderer wirtschaftlicher Bedingungen darstellt. Die Regel beschreibt insbesondere, wie die Zentralbank bei jedem Anstieg der Inflation um ein Prozent den Nominalzins um mehr als einen Prozentpunkt erhöhen kann. Dieser Aspekt der Regel wird oft als Taylor-Prinzip bezeichnet. Obwohl solche Regeln prägnante, beschreibende Proxies für die Zentralbankpolitik liefern, werden sie in der Praxis von den Zentralbanken bei der Festlegung der Nominalzinsen nicht explizit proskriptiv berücksichtigt.

Taylors ursprüngliche Version der Regel beschreibt, wie der Nominalzins auf Abweichungen der tatsächlichen Inflationsraten von den Zielinflationsraten und des tatsächlichen Bruttoinlandsprodukts (BIP) vom potenziellen BIP reagiert:

i t = π t + r t ∗ + a π (π t − π t ∗ ) + a y (y t − y t ∗) . {\displaystyle i_{t}=\pi _{t}+r_{t}^{*}+a_{\pi }(\pi _{t}-\pi _{t}^{*})+a_{y}(y_{t}-y_{t}^{*}).}

In dieser Gleichung ist i t {\displaystyle \,i_{t}}\,}

ist der kurzfristige nominale Zielzinssatz (z. die Federal Funds Rate in den USA, die Bank of England Basiszinssatz in Großbritannien), π t {\displaystyle \,\pi _{t}\,}

ist die Inflationsrate gemessen am BIP-Deflator π t ∗ {\displaystyle \pi _{t}^{*}}

ist die gewünschte Inflationsrate, r t ∗ {\displaystyle r_{t}^{*}}

ist der angenommene Gleichgewichtsrealzinssatz, y t {\displaystyle \,y_{t}\,}

ist der Logarithmus des realen BIP, und y t ∗ {\displaystyle y_{t}^{*}}

ist der Logarithmus des potenziellen Ausgangs, wie durch einen linearen Trend bestimmt.

Die neue keynesianische Phillips-Kurve

Die neue keynesianische Phillips-Kurve wurde ursprünglich 1995 von Roberts abgeleitet und wird seitdem in den meisten modernen New Keynesian DSGE-Modellen verwendet. Die neue keynesianische Phillips-Kurve besagt, dass die Inflation dieser Periode von der aktuellen Produktion und den Erwartungen der Inflation der nächsten Periode abhängt. Die Kurve wird aus dem dynamischen Calvo-Preismodell abgeleitet und ist mathematisch:

π t = β E t + κ y t {\displaystyle \pi _{t}=\beta E_{t}+\kappa y_{t}}

Die Erwartungen der aktuellen Periode t für die Inflation der nächsten Periode werden als β E t {\displaystyle \beta E_{t}}

, wobei β {\displaystyle \beta }

der Abzinsungsfaktor ist. Die Konstante κ {\displaystyle \kappa }

erfasst die Reaktion der Inflation auf die Produktion und wird weitgehend durch die Wahrscheinlichkeit bestimmt, den Preis in einem beliebigen Zeitraum zu ändern, der h {\displaystyle h}

: κ = h 1 − h γ {\displaystyle \kappa ={\frac {h}{1-h}}\gamma }

.

Je weniger starr die Nominalpreise sind (je höher h {\displaystyle h}

), je größer der Effekt der Produktion auf die aktuelle Inflation.

Die Wissenschaft der Geldpolitik

Die in den 1990er Jahren entwickelten Ideen wurden zusammengefügt, um das neue keynesianische Dynamische stochastische allgemeine Gleichgewicht zu entwickeln, das zur Analyse der Geldpolitik verwendet wird. Dies gipfelte in dem dreigleisigen neuen keynesianischen Modell, das in der Umfrage von Richard Clarida gefunden wurde, Jordi Gali, und Mark Gertler im Journal of Economic Literature,. Es kombiniert die beiden Gleichungen der neukeynesianischen Phillips-Kurve und der Taylor-Regel mit der dynamischen IS-Kurve, die aus der optimalen dynamischen Verbrauchsgleichung (Euler-Gleichung des Haushalts) abgeleitet ist.

y t = y t + 1 + 1 σ ( i t − E t π t + 1 ) + v t {\displaystyle y_{t}=y_{t+1}+{\frac {1}{\sigma }}(i_{t}-E_{t}\pi _{t+1})+v_{t}}

Diese drei Gleichungen bildeten ein relativ einfaches Modell, das für die theoretische Analyse politischer Fragen verwendet werden konnte. Das Modell wurde jedoch in mancher Hinsicht zu stark vereinfacht (z. B. gibt es kein Kapital oder keine Investition). Außerdem funktioniert es empirisch nicht gut.

2000Bearbeiten

Im neuen Jahrtausend gab es mehrere Fortschritte in der neukeynesianischen Ökonomie.

The introduction of imperfectly competitive labor marketsEdit

Während sich die Modelle der 1990er Jahre auf Sticky Prices auf dem Output-Markt konzentrierten, übernahmen Christopher Erceg, Dale Henderson und Andrew Levin im Jahr 2000 das Blanchard- und Kiyotaki-Modell gewerkschaftlich organisierter Arbeitsmärkte, indem sie es mit dem Calvo-Pricing-Ansatz kombinierten und in ein neues keynesianisches DSGE-Modell einführten.

Die Entwicklung komplexer DSGE-Modelle.Edit

Um Modelle zu haben, die gut mit den Daten funktionierten und für politische Simulationen verwendet werden konnten, wurden ziemlich komplizierte neue keynesianische Modelle mit mehreren Merkmalen entwickelt. Wegweisende Arbeiten wurden von Frank Smets und Rafael Wouters sowie von Lawrence J.. Christiano, Martin Eichenbaum und Charles Evans Die gemeinsamen Merkmale dieser Modelle umfassten:

- habit Persistenz. Der Grenznutzen des Verbrauchs hängt vom vergangenen Verbrauch ab.

- Calvo-Preisgestaltung sowohl auf den Produktions- als auch auf den Produktmärkten mit Indexierung, sodass Löhne und Preise, wenn sie nicht explizit zurückgesetzt werden, für die Inflation aktualisiert werden.

- Kapitalanpassungskosten und variable Kapitalverwendung.

- neue Schocks

- Nachfrageschocks, die den Grenznutzen des Verbrauchs beeinflussen

- Markup-Schocks, die den gewünschten Preisaufschlag gegenüber den Grenzkosten beeinflussen.

- die Geldpolitik wird durch eine Taylor-Regel dargestellt.

- Bayes’sche Schätzmethoden.

Sticky informationEdit

Die Idee der Sticky Information in Fischers Modell wurde später von Gregory Mankiw und Ricardo Reis entwickelt. Dies fügte dem Fischer-Modell eine neue Funktion hinzu: Es gibt eine feste Wahrscheinlichkeit, dass Sie Ihre Löhne oder Preise in jeder Periode neu planen können. Unter Verwendung vierteljährlicher Daten nahmen sie einen Wert von 25% an: Das heißt, jedes Quartal können 25% der zufällig ausgewählten Unternehmen / Gewerkschaften auf der Grundlage aktueller Informationen eine Entwicklung der aktuellen und zukünftigen Preise planen. Wenn wir also den aktuellen Zeitraum betrachten: 25% der Preise basieren auf den neuesten verfügbaren Informationen; der Rest auf Informationen, die verfügbar waren, als sie zuletzt in der Lage waren, ihre Preiskurve neu zu planen. Mankiw und Reis fanden heraus, dass das Modell der klebrigen Informationen eine gute Möglichkeit bietet, die Inflationsbeständigkeit zu erklären.

Die Informationsmodelle haben keine nominale Starrheit: Unternehmen oder Gewerkschaften können für jede Periode unterschiedliche Preise oder Löhne wählen. Es sind die Informationen, die klebrig sind, nicht die Preise. Wenn also ein Unternehmen Glück hat und seine aktuellen und zukünftigen Preise neu planen kann, wird es eine Flugbahn wählen, von der es glaubt, dass sie jetzt und in Zukunft die optimalen Preise sein wird. Im Allgemeinen bedeutet dies, dass für jeden vom Plan abgedeckten Zeitraum ein anderer Preis festgelegt wird. Dies steht im Widerspruch zu den empirischen Erkenntnissen über die Preise. Es gibt jetzt viele Studien zur Preisstarre in verschiedenen Ländern: den Vereinigten Staaten, der Eurozone, dem Vereinigten Königreich und anderen. Alle diese Studien zeigen, dass es zwar einige Sektoren gibt, in denen sich die Preise häufig ändern, es aber auch andere Sektoren gibt, in denen die Preise im Laufe der Zeit fest bleiben. Das Fehlen klebriger Preise im klebrigen Informationsmodell stimmt nicht mit dem Preisverhalten in den meisten Wirtschaftsbereichen überein. Dies hat zu Versuchen geführt, ein „Dual Stickiness“ -Modell zu formulieren, das klebrige Informationen mit klebrigen Preisen kombiniert.

2010Bearbeiten

In den 2010er Jahren wurden Modelle entwickelt, die die Heterogenität der Haushalte in das Standard-New-Keynesian-Framework einbeziehen und allgemein als HANK-Modelle (Heterogenous Agent New Keynesian) bezeichnet werden. Zusätzlich zu den klebrigen Preisen weist ein typisches HANK-Modell ein nicht versicherbares idiosynkratisches Arbeitseinkommensrisiko auf, das zu einer nicht degenerierten Vermögensverteilung führt. Zu den frühesten Modellen mit diesen beiden Merkmalen gehören Oh und Reis (2012), McKay und Reis (2016) und Guerrieri und Lorenzoni (2017).

Der Name „HANK-Modell“ wurde von Greg Kaplan, Benjamin Moll und Gianluca Violante in einem Papier aus dem Jahr 2018 geprägt, das Haushalte zusätzlich als Ansammlung von zwei Arten von Vermögenswerten modelliert, von denen eine liquide und die andere illiquide ist. Dies führt zu einer großen Heterogenität der Portfoliozusammensetzung in den Haushalten. Insbesondere passt das Modell zu empirischen Erkenntnissen, da es einen großen Anteil von Haushalten mit wenig liquidem Vermögen aufweist: die Hand-zu-Mund-Haushalte. In Übereinstimmung mit empirischen Erkenntnissen halten etwa zwei Drittel dieser Haushalte nicht triviale Mengen an illiquidem Vermögen, obwohl sie wenig liquides Vermögen besitzen. Diese Haushalte sind als wohlhabende Hand-zu-Mund-Haushalte bekannt, ein Begriff, der 2014 in einer Studie von Kaplan und Violante über fiskalische Stimuli eingeführt wurde.

Die Existenz wohlhabender Hand-zu-Mund-Haushalte in neuen keynesianischen Modellen ist für die Auswirkungen der Geldpolitik von Bedeutung, da das Konsumverhalten dieser Haushalte stark von Veränderungen des verfügbaren Einkommens und nicht von Schwankungen des Zinssatzes (d. h. des Zinssatzes) abhängt. der Preis des zukünftigen Verbrauchs im Verhältnis zum aktuellen Verbrauch). Die direkte Folge davon ist, dass die Geldpolitik hauptsächlich über allgemeine Gleichgewichtseffekte übertragen wird, die über das Arbeitseinkommen der Haushalte wirken, und nicht über die intertemporale Substitution, die der Hauptübertragungskanal in repräsentativen Agent New Keynesian (RANK) Modellen ist.

Es gibt zwei wesentliche Implikationen für die Geldpolitik. Erstens interagiert die Geldpolitik stark mit der Fiskalpolitik, da die ricardische Äquivalenz aufgrund der Anwesenheit von Hand-zu-Mund-Haushalten versagt. Insbesondere Änderungen des Zinssatzes verschieben die Budgetbeschränkung der Regierung, und die fiskalische Reaktion auf diese Verschiebung wirkt sich auf das verfügbare Einkommen der privaten Haushalte aus. Zweitens sind aggregierte monetäre Schocks nicht verteilungsneutral, da sie die Kapitalrendite beeinflussen, was Haushalte mit unterschiedlichem Vermögen und Vermögen unterschiedlich beeinflusst.