- 1970sEdit

- 1980sEdit

- Coûts des menus et concurrence imparfaite

- Le modèle des contrats échelonnés de Calvodit

- Échec de la coordinationmodifier

- Défaillances du marché du travail: salaires d’efficacitémodifier

- 1990sEdit

- La nouvelle synthèse néoclassiquedit

- Règle de Taylor

- La Nouvelle courbe de Phillips Keynésienedit

- La Science de la politique monétaire

- 2000sEdit

- L’introduction de marchés du travail imparfaitement concurrencésmodifier

- Le développement de modèles DSGE complexes.Edit

- Informations collantes

- 2010sEdit

1970sEdit

La première vague de Nouvelle économie keynésienne s’est développée à la fin des années 1970. Le premier modèle d’information collante a été développé par Stanley Fischer dans son article de 1977, Contrats à long terme, Attentes rationnelles et Règle de la Masse monétaire Optimale. Il a adopté un modèle de contrat « échelonné » ou « superposé ». Supposons qu’il y ait deux syndicats dans l’économie, qui choisissent à tour de rôle les salaires. Lorsque c’est au tour d’un syndicat, il choisit les salaires qu’il fixera pour les deux prochaines périodes. Cela contraste avec John B. Le modèle de Taylor où le salaire nominal est constant sur la durée du contrat, comme cela a été développé par la suite dans ses deux articles, dont l’un en 1979 « La fixation échelonnée des salaires dans un modèle macro ». et un en 1980 « Dynamique agrégée et Contrats Échelonnés ». Les contrats Taylor et Fischer partagent la caractéristique que seuls les syndicats qui fixent le salaire au cours de la période actuelle utilisent les informations les plus récentes: les salaires dans la moitié de l’économie reflètent toujours des informations anciennes. Le modèle Taylor avait des salaires nominaux collants en plus des informations collantes: les salaires nominaux devaient être constants sur toute la durée du contrat (deux périodes). Ces premières nouvelles théories keynésiennes étaient basées sur l’idée de base que, compte tenu des salaires nominaux fixes, une autorité monétaire (la banque centrale) peut contrôler le taux d’emploi. Les salaires étant fixés à un taux nominal, l’autorité monétaire peut contrôler le salaire réel (valeurs des salaires ajustées en fonction de l’inflation) en modifiant la masse monétaire et ainsi affecter le taux d’emploi.

1980sEdit

Dans les années 1980, le concept clé consistant à utiliser les coûts des menus dans un cadre de concurrence imparfaite pour expliquer la rigidité des prix a été développé. Le concept d’un coût forfaitaire (coût du menu) pour changer le prix a été introduit à l’origine par Sheshinski et Weiss (1977) dans leur article examinant l’effet de l’inflation sur la fréquence des changements de prix. L’idée de l’appliquer comme théorie générale de la rigidité des prix nominaux a été simultanément avancée par plusieurs économistes en 1985-6. George Akerlof et Janet Yellen ont avancé l’idée qu’en raison d’une rationalité limitée, les entreprises ne voudront pas modifier leur prix à moins que l’avantage ne soit plus qu’un petit montant. Cette rationalité bornée conduit à une inertie des prix nominaux et des salaires qui peut conduire à une fluctuation de la production à des prix nominaux et des salaires constants. Gregory Mankiw a repris l’idée du coût du menu et s’est concentré sur les effets sur le bien-être des variations de la production résultant de prix collants. Michael Parkin a également avancé l’idée. Bien que l’approche se soit initialement concentrée principalement sur la rigidité des prix nominaux, elle a été étendue aux salaires et aux prix par Olivier Blanchard et Nobuhiro Kiyotaki dans leur article influent Concurrence monopolistique et effets de la demande globale. Huw Dixon et Claus Hansen ont montré que même si les coûts du menu s’appliquaient à un petit secteur de l’économie, cela influencerait le reste de l’économie et amènerait les prix dans le reste de l’économie à moins réagir aux changements de la demande.

Alors que certaines études suggèrent que les coûts des menus sont trop faibles pour avoir un impact global important, Laurence Ball et David Romer ont montré en 1990 que les rigidités réelles pouvaient interagir avec les rigidités nominales pour créer un déséquilibre significatif. Des rigidités réelles se produisent chaque fois qu’une entreprise tarde à ajuster ses prix réels en réponse à un environnement économique changeant. Par exemple, une entreprise peut faire face à de réelles rigidités si elle a un pouvoir de marché ou si ses coûts d’intrants et de salaires sont bloqués par un contrat. Ball et Romer ont fait valoir que les rigidités réelles du marché du travail maintiennent les coûts élevés d’une entreprise, ce qui rend les entreprises hésitantes à réduire les prix et à perdre des revenus. La dépense créée par les rigidités réelles combinées au coût de menu de la variation des prix rend moins probable que l’entreprise réduise les prix à un niveau de compensation du marché.

Même si les prix sont parfaitement flexibles, une concurrence imparfaite peut affecter l’influence de la politique fiscale en termes de multiplicateur. Huw Dixon et Gregory Mankiw ont développé indépendamment des modèles d’équilibre général simples montrant que le multiplicateur fiscal pourrait augmenter avec le degré de concurrence imparfaite sur le marché de la production. La raison en est que la concurrence imparfaite sur le marché de la production tend à réduire le salaire réel, ce qui conduit le ménage à se substituer à la consommation au profit des loisirs. Lorsque les dépenses publiques augmentent, l’augmentation correspondante de la fiscalité forfaitaire entraîne une diminution à la fois des loisirs et de la consommation (en supposant qu’ils sont tous deux un bien normal). Plus le degré de concurrence imparfaite sur le marché de la production est élevé, plus le salaire réel est bas et donc plus la réduction se répercute sur les loisirs (c’est-à-dire que les ménages travaillent plus) et moins sur la consommation. Par conséquent, le multiplicateur fiscal est inférieur à un, mais augmente dans le degré de concurrence imparfaite sur le marché de la production.

Le modèle des contrats échelonnés de Calvodit

En 1983, Guillermo Calvo a écrit « Prix décalés dans un cadre maximisant les services publics ». L’article original a été écrit dans un cadre mathématique en temps continu, mais est aujourd’hui principalement utilisé dans sa version en temps discret. Le modèle Calvo est devenu le moyen le plus courant de modéliser la rigidité nominale dans les nouveaux modèles keynésiens. Il existe une probabilité que l’entreprise puisse réinitialiser son prix au cours d’une période h (le taux de risque), ou de manière équivalente la probabilité (1-h) que le prix reste inchangé au cours de cette période (le taux de survie). La probabilité h est parfois appelée « probabilité de Calvo » dans ce contexte. Dans le modèle Calvo, la caractéristique cruciale est que le fixateur de prix ne sait pas combien de temps le prix nominal restera en place, contrairement au modèle Taylor où la durée du contrat est connue ex ante.

Échec de la coordinationmodifier

L’échec de la coordination était un autre nouveau concept keynésien important développé comme une autre explication potentielle des récessions et du chômage. Dans les récessions, une usine peut tourner au ralenti même s’il y a des gens prêts à y travailler et des gens prêts à acheter sa production s’ils avaient un emploi. Dans un tel scénario, les ralentissements économiques semblent être le résultat d’un échec de coordination: la main invisible ne parvient pas à coordonner le flux habituel, optimal, de production et de consommation. L’article de 1988 de Russell Cooper et Andrew John sur la coordination des échecs de coordination dans les modèles keynésiens exprimait une forme générale de coordination en tant que modèles à équilibres multiples où les agents pouvaient se coordonner pour améliorer (ou du moins ne pas nuire) chacune de leurs situations respectives. Cooper et John ont basé leurs travaux sur des modèles antérieurs, y compris le modèle coconut de Peter Diamond en 1982, qui a démontré un cas d’échec de la coordination impliquant la théorie de la recherche et de l’appariement. Dans le modèle du diamant, les producteurs sont plus susceptibles de produire s’ils voient d’autres produire. L’augmentation du nombre de partenaires commerciaux possibles augmente la probabilité qu’un producteur donné trouve quelqu’un avec qui commercer. Comme dans d’autres cas d’échec de coordination, le modèle de Diamond a de multiples équilibres, et le bien-être d’un agent dépend des décisions des autres. Le modèle de Diamond est un exemple d' »externalité du marché épais » qui fait que les marchés fonctionnent mieux lorsque plus de personnes et d’entreprises y participent. Les prophéties auto-réalisatrices sont d’autres sources potentielles d’échec de la coordination. Si une entreprise anticipe une baisse de la demande, elle pourrait réduire ses embauches. Le manque de postes vacants peut inquiéter les travailleurs qui réduisent ensuite leur consommation. Cette baisse de la demande répond aux attentes de l’entreprise, mais elle est entièrement due aux propres actions de l’entreprise.

Défaillances du marché du travail: salaires d’efficacitémodifier

Les nouveaux keynésiens ont offert des explications à l’échec du marché du travail. Dans un marché walrasien, les travailleurs sans emploi soumettent des offres de salaire jusqu’à ce que la demande de travailleurs réponde à l’offre. Si les marchés sont walrasiens, les rangs des chômeurs seraient limités aux travailleurs en transition entre un emploi et aux travailleurs qui choisissent de ne pas travailler parce que les salaires sont trop bas pour les attirer. Ils ont développé plusieurs théories expliquant pourquoi les marchés pourraient laisser des travailleurs volontaires au chômage. La plus importante de ces théories, les nouveaux Keynésiens, était la théorie des salaires d’efficacité utilisée pour expliquer les effets à long terme du chômage antérieur, où les augmentations à court terme du chômage deviennent permanentes et conduisent à des niveaux de chômage plus élevés à long terme.

Dans les modèles de salaires d’efficacité, les travailleurs sont payés à des niveaux qui maximisent la productivité au lieu de libérer le marché. Par exemple, dans les pays en développement, les entreprises peuvent payer plus qu’un taux du marché pour s’assurer que leurs travailleurs ont les moyens de se nourrir suffisamment pour être productifs. Les entreprises pourraient également payer des salaires plus élevés pour accroître leur loyauté et leur moral, ce qui pourrait conduire à une meilleure productivité. Les entreprises peuvent également payer plus cher que les salaires du marché pour éviter de se dérober. Les modèles d’esquive étaient particulièrement influents.L’article de Carl Shapiro et Joseph Stiglitz, paru en 1984, Equilibrium Unemployment as a Worker Discipline Device, a créé un modèle dans lequel les employés ont tendance à éviter le travail, à moins que les entreprises ne puissent surveiller l’effort des travailleurs et menacer de chômage les employés qui relâchent. Si l’économie est au plein emploi, un fuyard licencié se déplace simplement vers un nouvel emploi. Les entreprises individuelles paient à leurs travailleurs une prime supérieure au taux du marché pour s’assurer que leurs travailleurs préfèrent travailler et conserver leur emploi actuel au lieu de se dérober et de risquer de devoir déménager vers un nouvel emploi. Étant donné que chaque entreprise paie plus que les salaires de compensation du marché, le marché du travail agrégé ne parvient pas à se dégager. Cela crée un bassin de travailleurs au chômage et augmente les frais de licenciement. Les travailleurs risquent non seulement un salaire plus bas, mais ils risquent d’être coincés dans le bassin de chômeurs. Maintenir les salaires au-dessus des niveaux de compensation du marché crée une sérieuse dissuasion de se dérober qui rend les travailleurs plus efficaces même si cela laisse certains travailleurs volontaires au chômage.

1990sEdit

La nouvelle synthèse néoclassiquedit

Au début des années 1990, les économistes ont commencé à combiner les éléments de la nouvelle économie keynésienne développée dans les années 1980 et plus tôt avec la Théorie du cycle économique réel. Les modèles RBC étaient dynamiques mais supposaient une concurrence parfaite; les nouveaux modèles keynésiens étaient principalement statiques mais basés sur une concurrence imparfaite. La Nouvelle synthèse néoclassique combinait essentiellement les aspects dynamiques de la RBC avec une concurrence imparfaite et les rigidités nominales des nouveaux modèles keynésiens. Tack Yun a été l’un des premiers à le faire, dans un modèle qui utilisait le modèle de tarification Calvo. Goodfriend et King ont proposé une liste de quatre éléments qui sont au cœur de la nouvelle synthèse: l’optimisation intertemporelle, les attentes rationnelles, la concurrence imparfaite et l’ajustement coûteux des prix (coûts du menu). Goodfriend et King constatent également que les modèles de consensus ont certaines implications politiques: alors que la politique monétaire peut affecter la production réelle à court terme, il n’y a pas de compromis à long terme: la monnaie n’est pas neutre à court terme, mais elle l’est à long terme. L’inflation a des effets négatifs sur le bien-être. Il est important que les banques centrales conservent leur crédibilité grâce à une politique fondée sur des règles, comme le ciblage de l’inflation.

Règle de Taylor

En 1993, John B Taylor a formulé l’idée d’une règle de Taylor, qui est une approximation sous forme réduite de la réactivité du taux d’intérêt nominal, tel que fixé par la banque centrale, aux variations de l’inflation, de la production ou d’autres conditions économiques. En particulier, la règle décrit comment, pour chaque augmentation d’un pour cent de l’inflation, la banque centrale a tendance à augmenter le taux d’intérêt nominal de plus d’un point de pourcentage. Cet aspect de la règle est souvent appelé le principe de Taylor. Bien que ces règles fournissent des substituts concis et descriptifs pour la politique des banques centrales, elles ne sont pas, dans la pratique, explicitement proscrites par les banques centrales lors de la fixation des taux nominaux.

La version originale de la règle de Taylor décrit comment le taux d’intérêt nominal réagit aux différences entre les taux d’inflation réels et les taux d’inflation cibles et entre le Produit intérieur brut (PIB) réel et le PIB potentiel:

i t = π t + r t ∗ + a π (π t-π t ∗) + a y (y t− y t ∗). {\displaystyle i_{t} = \pi_{t} + r_{t}^{*} +a_{\pi}(\pi_{t}-\pi_{t}^{*}) +a_{y}(y_{t}-y_{t}^{*}).}

Dans cette équation, i t {\displaystyle\, i_{t}\,}

est le taux d’intérêt nominal à court terme cible (p. ex. le taux des fonds fédéraux aux États-Unis, le taux de base de la Banque d’Angleterre au Royaume-Uni), π t {\displaystyle\,\pi_{t}\,}

est le taux d’inflation mesuré par le déflateur du PIB, π t ∗ {\displaystyle\pi_{t}^{*}}

est le taux d’inflation souhaité, r t ∗ {\displaystyle r_{t}^{*}}

est le taux d’intérêt réel d’équilibre supposé, y t {\displaystyle\, y_{t}\,}

est le logarithme du PIB réel, et y t ∗ {\displaystyle y_{t}^{*}}

est le logarithme de la sortie potentielle, tel que déterminé par une tendance linéaire.

La Nouvelle courbe de Phillips Keynésienedit

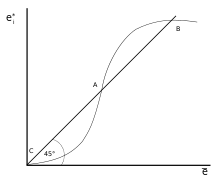

La Nouvelle courbe de Phillips Keynésienne a été dérivée à l’origine par Roberts en 1995 et a depuis été utilisée dans la plupart des Nouveaux modèles DSGE keynésiens de pointe. La nouvelle courbe keynésienne de Phillips indique que l’inflation de cette période dépend de la production actuelle et des anticipations d’inflation de la prochaine période. La courbe est dérivée du modèle de tarification Calvo dynamique et, en termes mathématiques, est:

π t = β E t + κ y t {\displaystyle\pi_{t} = \beta E_ {t} +\kappa y_ {t}}

Les anticipations de l’inflation de la période en cours sont incorporées en tant que β E t {\displaystyle\beta E_ {t}}

, où β{\displaystyle\beta}

est le facteur d’actualisation. La constante κ{\displaystyle\kappa}

capture la réponse de l’inflation à la production, et est largement déterminée par la probabilité de variation des prix au cours d’une période donnée, qui est h {\displaystyle h}

: κ= h 1-h γ {\displaystyle\kappa = {\frac{h}{1-h}}\gamma}

.

Moins les prix nominaux sont rigides (plus h est élevé {\displaystyle h}

), plus l’effet de la production sur l’inflation actuelle est important.

La Science de la politique monétaire

Les idées développées dans les années 1990 ont été rassemblées pour développer le nouvel équilibre général stochastique dynamique keynésien utilisé pour analyser la politique monétaire. Cela a abouti au nouveau modèle keynésien à trois équations trouvé dans l’enquête de Richard Clarida, Jordi Gali et Mark Gertler dans le Journal of Economic Literature,. Il combine les deux équations de la nouvelle courbe keynésienne de Phillips et de la règle de Taylor avec la courbe dynamique IS dérivée de l’équation de consommation dynamique optimale (équation d’Euler du ménage).

y t = y t + 1 +1 σ (i t−E t π t +1) + v t {\displaystyle y_ {t} = y_{t+1} +{\frac{1}{\sigma}} (i_{t}-E_{t}\pi_{t+1}) +v_{t}}

Ces trois équations formaient un modèle relativement simple qui pouvait être utilisé pour l’analyse théorique des questions de politique générale. Cependant, le modèle a été simplifié à certains égards (par exemple, il n’y a pas de capital ou d’investissement). De plus, il ne fonctionne pas bien empiriquement.

2000sEdit

Au cours du nouveau millénaire, il y a eu plusieurs avancées dans la nouvelle économie keynésienne.

L’introduction de marchés du travail imparfaitement concurrencésmodifier

Alors que les modèles des années 1990 étaient axés sur des prix collants sur le marché de la production, Christopher Erceg, Dale Henderson et Andrew Levin ont adopté en 2000 le modèle Blanchard et Kiyotaki des marchés du travail syndiqués en le combinant avec l’approche de prix Calvo et en l’introduisant dans un nouveau modèle keynésien de DSGE.

Le développement de modèles DSGE complexes.Edit

Afin d’avoir des modèles qui fonctionnaient bien avec les données et pourraient être utilisés pour des simulations de politiques, de nouveaux modèles keynésiens assez compliqués ont été développés avec plusieurs fonctionnalités. Des articles fondateurs ont été publiés par Frank Smets et Rafael Wouters et aussi Lawrence J. Christiano, Martin Eichenbaum et Charles Evans Les caractéristiques communes de ces modèles comprenaient:

- persistance de l’habitude. L’utilité marginale de la consommation dépend de la consommation passée.

- Prix Calvo sur les marchés de la production et des produits, avec indexation de sorte que lorsque les salaires et les prix ne sont pas explicitement réinitialisés, ils sont mis à jour pour tenir compte de l’inflation.

- coûts d’ajustement du capital et utilisation variable du capital.

- nouveaux chocs

- chocs de demande, qui affectent l’utilité marginale de la consommation

- chocs de majoration qui influencent la majoration souhaitée du prix sur le coût marginal.

- la politique monétaire est représentée par une règle de Taylor.

- Méthodes d’estimation bayésiennes.

Informations collantes

L’idée de l’information collante trouvée dans le modèle de Fischer a ensuite été développée par Gregory Mankiw et Ricardo Reis. Cela a ajouté une nouvelle fonctionnalité au modèle de Fischer: il y a une probabilité fixe que vous puissiez rejouer vos salaires ou vos prix à chaque période. En utilisant des données trimestrielles, ils ont supposé une valeur de 25%: c’est-à-dire que chaque trimestre, 25% des entreprises / syndicats choisis au hasard peuvent planifier une trajectoire des prix actuels et futurs sur la base des informations actuelles. Ainsi, si l’on considère la période en cours: 25% des prix seront basés sur les dernières informations disponibles; le reste sur les informations qui étaient disponibles lors de la dernière fois qu’elles ont pu replanifier leur trajectoire de prix. Mankiw et Reis ont constaté que le modèle d’information collante fournissait un bon moyen d’expliquer la persistance de l’inflation.

Les modèles d’information collante n’ont pas de rigidité nominale: les entreprises ou les syndicats sont libres de choisir des prix ou des salaires différents pour chaque période. Ce sont les informations qui sont collantes, pas les prix. Ainsi, lorsqu’une entreprise aura de la chance et pourra planifier à nouveau ses prix actuels et futurs, elle choisira une trajectoire de ce qu’elle estime être les prix optimaux maintenant et à l’avenir. En général, cela impliquera de fixer un prix différent à chaque période couverte par le plan. Ceci est en contradiction avec les preuves empiriques sur les prix. Il existe maintenant de nombreuses études sur la rigidité des prix dans différents pays: les États-Unis, la zone euro, le Royaume-Uni et d’autres. Ces études montrent toutes que s’il existe certains secteurs où les prix changent fréquemment, il existe également d’autres secteurs où les prix restent fixes dans le temps. L’absence de prix collants dans le modèle d’information collante est incompatible avec le comportement des prix dans la majeure partie de l’économie. Cela a conduit à des tentatives de formulation d’un modèle de « double viscosité » qui combine des informations collantes avec des prix collants.

2010sEdit

Les années 2010 ont vu le développement de modèles intégrant l’hétérogénéité des ménages dans le Nouveau cadre keynésien standard, communément appelés modèles « HANK » (Agent hétérogène Nouveau Keynésien). En plus des prix collants, un modèle HANK typique comporte un risque de revenu du travail idiosyncratique non assuré qui donne lieu à une distribution de la richesse non dégénérée. Les premiers modèles avec ces deux caractéristiques comprennent Oh et Reis (2012), McKay et Reis (2016) et Guerrieri et Lorenzoni (2017).

Le nom de « modèle HANK » a été inventé par Greg Kaplan, Benjamin Moll et Gianluca Violante dans un article de 2018 qui modélise en outre les ménages comme accumulant deux types d’actifs, l’un liquide, l’autre illiquide. Cela se traduit par une riche hétérogénéité dans la composition du portefeuille d’un ménage à l’autre. En particulier, le modèle s’adapte aux données empiriques en mettant en évidence une grande partie des ménages détenant peu de richesse liquide: les ménages « de la main à la bouche ». Conformément aux données empiriques, environ les deux tiers de ces ménages détiennent des quantités non négligeables de richesse illiquide, bien que détenant peu de richesse liquide. Ces ménages sont connus sous le nom de ménages riches, un terme introduit dans une étude de 2014 sur les politiques de relance budgétaire par Kaplan et Violante.

L’existence de ménages riches au corps à corps dans les nouveaux modèles keynésiens compte pour les effets de la politique monétaire, car le comportement de consommation de ces ménages est fortement sensible aux variations du revenu disponible, plutôt qu’aux variations du taux d’intérêt (i.e. le prix de la consommation future par rapport à la consommation actuelle). Le corollaire direct est que la politique monétaire est principalement transmise par des effets d’équilibre général qui fonctionnent à travers le revenu du travail des ménages, plutôt que par la substitution intertemporelle, qui est le principal canal de transmission des Nouveaux modèles keynésiens (RANK) d’agents représentatifs.

Il y a deux implications principales pour la politique monétaire. Premièrement, la politique monétaire interagit fortement avec la politique budgétaire, en raison de l’échec de l’équivalence ricardienne due à la présence de ménages au bouche-à-oreille. En particulier, les changements dans le changement de taux d’intérêt la contrainte budgétaire du gouvernement et la réponse fiscale à ce changement affectent le revenu disponible des ménages. Deuxièmement, les chocs monétaires agrégés ne sont pas neutres sur le plan de la répartition puisqu’ils affectent le rendement du capital, ce qui affecte différemment les ménages dont les niveaux de richesse et d’actifs diffèrent.