- 1970sEdit

- 1980sEdit

- koszty Menu i niedoskonała Konkurencjaedit

- Model kontraktów Calvo staggered

- brak koordynacji

- niepowodzenia na rynku pracy: zakłady efektywności

- 1990sEdit

- Nowa neoklasyczna syntezaedit

- zasada Tayloraedytuj

- Nowy Keynesian Phillips curveEdit

- Nauka o polityce Pieniężnejedytuj

- 2000sEdit

- wprowadzenie niedoskonale konkurencyjnych rynkówedytuj

- opracowanie złożonych modeli DSGE.Edit

- lepkie informacjeedit

- 2010sEdit

1970sEdit

pierwsza fala New Keynesian economics rozwinęła się pod koniec lat 70. pierwszy model lepkiej informacji został opracowany przez Stanleya Fischera w jego artykule z 1977 r., Long-Term Contracts, Rational Expectations, and the Optimal Money Supply Rule. Przyjął model kontraktu” rozłożonego „lub” nakładającego się”. Załóżmy, że w gospodarce istnieją dwa związki zawodowe, które na zmianę wybierają płace. Kiedy przychodzi kolej na związek, wybiera wynagrodzenie, które będzie ustalać na kolejne dwa okresy. Kontrastuje to z Johnem B. Model Taylora, w którym płaca nominalna jest stała przez cały okres obowiązywania umowy, został następnie opracowany w jego dwóch artykułach, jednym z nich w 1979 roku „Staggered wage setting in a macro model”. i jeden w 1980 „Aggregate Dynamics and Staggered Contracts”. Zarówno umowy Taylora, jak i Fischera podzielają tę cechę, że tylko związki zawodowe ustalające wynagrodzenie w bieżącym okresie korzystają z najnowszych informacji: płace w połowie gospodarki wciąż odzwierciedlają stare informacje. Model Taylora miał lepkie płace nominalne oprócz lepkich informacji: płace nominalne musiały być stałe przez cały okres trwania umowy (dwa okresy). Te wczesne teorie Keynesowskie opierały się na założeniu, że przy stałych płacach nominalnych władza monetarna (bank centralny) może kontrolować stopę zatrudnienia. Ponieważ płace są ustalane według stopy nominalnej, władza monetarna może kontrolować płace realne (wartości płac skorygowane o inflację) poprzez zmianę podaży pieniądza, a tym samym wpływać na stopę zatrudnienia.

1980sEdit

koszty Menu i niedoskonała Konkurencjaedit

w latach 80.opracowano kluczową koncepcję wykorzystania kosztów menu w ramach niedoskonałej konkurencji w celu wyjaśnienia lepkości cen. Pojęcie kosztu ryczałtowego (koszt menu) do zmiany ceny zostało pierwotnie wprowadzone przez Sheshinskiego i Weissa (1977) w ich artykule, badającym wpływ inflacji na częstotliwość zmian cen. Pomysł zastosowania go jako ogólnej teorii sztywności ceny nominalnej został jednocześnie wysunięty przez kilku ekonomistów w latach 1985-1986. George Akerlof i Janet Yellen wysunęli pogląd, że ze względu na ograniczoną racjonalność firmy nie będą chciały zmieniać swojej ceny, chyba że korzyść będzie większa niż niewielka kwota. Ta ograniczona racjonalność prowadzi do bezwładności cen nominalnych i płac, co może prowadzić do wahań produkcji przy stałych cenach nominalnych i płacach. Grzegorz Mankiw wziął pomysł menu-cost i skupił się na efektach zmian w produkcji wynikających z lepkich cen. Michael Parkin również wysunął ten pomysł. Chociaż początkowo podejście skupiało się głównie na sztywności cen nominalnych, Olivier Blanchard i Nobuhiro Kiyotaki w swoim wpływowym artykule Monopolistic Competition and the Effects of Aggregate Demand rozszerzyli je na płace i ceny . Huw Dixon i Claus Hansen pokazali, że nawet jeśli koszty menu zostaną zastosowane do małego sektora gospodarki, wpłynie to na resztę gospodarki i doprowadzi do tego, że ceny w pozostałej części gospodarki będą mniej reagować na zmiany popytu.

podczas gdy niektóre badania sugerowały, że koszty menu są zbyt małe, aby miały duży wpływ zagregowany, Laurence Ball i David Romer wykazali w 1990 roku, że rzeczywiste sztywności mogą wchodzić w interakcje z nominalnymi sztywnościami, aby stworzyć znaczącą nierównowagę. Realne sztywność występuje wtedy, gdy firma powoli dostosowuje swoje realne ceny w odpowiedzi na zmieniające się otoczenie gospodarcze. Na przykład firma może stawić czoła realnym sztywnościom, jeśli ma siłę rynkową lub jeśli jej koszty nakładów i płac są zablokowane przez umowę. Ball i Romer twierdzili, że realne sztywności na rynku pracy utrzymują wysokie koszty firmy, co sprawia, że firmy wahają się obniżać ceny i tracić przychody. Wydatek spowodowany realnymi sztywnościami w połączeniu z kosztem zmiany cen sprawia, że jest mniej prawdopodobne, że firma obniży ceny do poziomu rynkowego.

nawet jeśli ceny są całkowicie elastyczne, niedoskonała konkurencja może wpływać na wpływ polityki fiskalnej pod względem mnożnika. Huw Dixon i Gregory Mankiw opracowali niezależnie proste modele równowagi ogólnej pokazujące, że mnożnik fiskalny może wzrastać wraz ze stopniem niedoskonałej konkurencji na rynku produkcji. Powodem tego jest to, że niedoskonała konkurencja na rynku produkcji ma tendencję do obniżania płac realnych, co prowadzi do tego, że gospodarstwo domowe rezygnuje z konsumpcji na rzecz wypoczynku. Wraz ze wzrostem wydatków rządowych, odpowiedni wzrost opodatkowania ryczałtowego powoduje zmniejszenie zarówno czasu wolnego, jak i konsumpcji (zakładając, że oba te dobra są normalnym dobrem). Im większy jest stopień niedoskonałej konkurencji na rynku produkcji, tym niższa jest płaca realna, a co za tym idzie, tym bardziej redukcja spada na wypoczynek (tzn. gospodarstwa domowe pracują więcej), a mniej na konsumpcję. W związku z tym mnożnik fiskalny jest mniejszy niż jeden, ale zwiększa się stopień niedoskonałej konkurencji na rynku produkcji.

Model kontraktów Calvo staggered

w 1983 roku Guillermo Calvo napisał „Staggered Prices in a Utility-Maximizing Framework”. Oryginalny artykuł został napisany w ramach matematycznych czasu ciągłego, ale obecnie jest najczęściej używany w jego dyskretnej wersji czasu. Model Calvo stał się najczęstszym sposobem modelowania sztywności nominalnej w nowych modelach Keynesowskich. Istnieje prawdopodobieństwo, że firma może zresetować swoją cenę w dowolnym okresie h (stopa ryzyka) lub równoważnie Prawdopodobieństwo (1-h), że cena pozostanie niezmieniona w tym okresie (stopa przetrwania). Prawdopodobieństwo h jest czasami nazywane „prawdopodobieństwem Calvo” w tym kontekście. W modelu Calvo kluczową cechą jest to, że podmiot ustalający cenę nie wie, jak długo cena nominalna pozostanie na miejscu, w przeciwieństwie do modelu Taylora, w którym długość kontraktu jest znana ex ante.

brak koordynacji

niepowodzenie koordynacji było kolejną ważną nową koncepcją Keynesowską opracowaną jako kolejne potencjalne Wyjaśnienie recesji i bezrobocia. W recesjach fabryka może iść bezczynnie, mimo że są ludzie chętni do pracy w niej, a ludzie chętni do zakupu jej produkcji, jeśli mieli pracę. W takim scenariuszu pogorszenie koniunktury wydaje się być wynikiem braku koordynacji: niewidzialna ręka nie koordynuje zwykłego, optymalnego przepływu produkcji i konsumpcji. W pracy Russella Coopera i Andrew Johna z 1988 r.coordinating coordination Failures in Keynesian Models wyrażono ogólną formę koordynacji jako modeli z wieloma równowagami, w których agenci mogli koordynować, aby poprawić (lub przynajmniej nie zaszkodzić) każdą z ich sytuacji. Cooper i John oparli swoje prace na wcześniejszych modelach, w tym modelu kokos Petera Diamonda z 1982 roku, który wykazał przypadek braku koordynacji z teorią wyszukiwania i dopasowywania. W modelu Diamond producenci są bardziej skłonni do produkcji, jeśli zobaczą innych produkujących. Wzrost liczby potencjalnych partnerów handlowych zwiększa prawdopodobieństwo, że dany producent znajdzie kogoś do handlu. Podobnie jak w innych przypadkach braku koordynacji, Model Diamonda ma wiele równowag, a dobro jednego czynnika zależy od decyzji innych. Model Diamond jest przykładem „grubego rynku zewnętrznego”, który powoduje, że rynki lepiej funkcjonują, gdy uczestniczy w nich więcej osób i firm. Inne potencjalne źródła niepowodzenia koordynacji obejmują samospełniające się proroctwa. Jeśli firma przewiduje spadek popytu, mogą ograniczyć zatrudnienie. Brak wolnych miejsc pracy może niepokoić pracowników, którzy następnie ograniczają konsumpcję. Ten spadek popytu spełnia oczekiwania firmy, ale jest to w całości spowodowane własnymi działaniami firmy.

niepowodzenia na rynku pracy: zakłady efektywności

nowi Keynesianie przedstawili wyjaśnienia niepowodzeń na rynku pracy. Na rynku Walraskim bezrobotni płacą w dół, dopóki popyt na pracowników nie zaspokoi podaży. Gdyby rynek był Walraski, szeregi bezrobotnych ograniczałyby się do pracowników przechodzących z pracy na pracę i do tych, którzy nie chcą pracować, ponieważ płace są zbyt niskie, aby ich przyciągnąć. Opracowali kilka teorii wyjaśniających, dlaczego rynki mogą pozostawić chętnych pracowników bez pracy. Najważniejszą z tych teorii, new Keynesians, była teoria płac efektywności używana do wyjaśnienia długoterminowych skutków poprzedniego bezrobocia, gdzie krótkotrwałe wzrosty bezrobocia stają się trwałe i prowadzą do wyższych poziomów bezrobocia w dłuższej perspektywie.

w modelach płac efektywnościowych pracownicy otrzymują wynagrodzenie na poziomie maksymalizującym produktywność, a nie oczyszczającym rynek. Na przykład w krajach rozwijających się firmy mogą płacić więcej niż rynkową stawkę, aby zapewnić swoim pracownikom wystarczającą ilość pożywienia, aby mogli być produktywni. Firmy mogą również płacić wyższe płace, aby zwiększyć lojalność i morale, co może prowadzić do lepszej wydajności. Firmy mogą również płacić wyższe niż rynkowe płace, aby uniknąć uchylania się. Szczególnie wpływowe były modelki uchylające się od pracy.Praca Carla Shapiro i Josepha Stiglitza z 1984 r. na temat bezrobocia równowagi jako urządzenia dyscypliny pracowników stworzyła model, w którym pracownicy mają tendencję do unikania pracy, chyba że firmy mogą monitorować wysiłek pracowników i grozić zwolnieniem pracowników bezrobociem. Jeśli gospodarka jest w pełnym zatrudnieniu, zwolniony shirker po prostu przenosi się do nowej pracy. Poszczególne firmy płacą swoim pracownikom premię ponad stawkę rynkową, aby upewnić się, że ich pracownicy wolą pracować i utrzymać swoją obecną pracę, zamiast uchylać się i ryzykować przejście do nowej pracy. Ponieważ każda firma płaci więcej niż płace rozliczane na rynku, zagregowany rynek pracy nie jest rozliczany. Tworzy to pulę bezrobotnych pracowników i zwiększa koszty zwolnienia. Pracownicy nie tylko ryzykują niższą płacę, ale także mogą utknąć w Puli bezrobotnych. Utrzymanie płac powyżej poziomu rozliczeń rynkowych powoduje poważne zniechęcenie do uchylania się od pracy, co sprawia, że pracownicy są bardziej wydajni, mimo że niektórzy chętni pracownicy pozostają bezrobotni.

1990sEdit

Nowa neoklasyczna syntezaedit

na początku lat 90.ekonomiści zaczęli łączyć elementy nowej ekonomii keynesowskiej rozwijanej w latach 80. i wcześniej z rzeczywistą teorią cyklu koniunkturalnego. Modele RBC były dynamiczne, ale zakładały doskonałą konkurencję; nowe modele Keynesowskie były przede wszystkim statyczne, ale oparte na niedoskonałej konkurencji. Nowa synteza neoklasyczna zasadniczo łączyła dynamiczne aspekty RBC z niedoskonałą konkurencją i nominalną sztywnością nowych modeli Keynesowskich. Tack Yun był jednym z pierwszych, którzy to zrobili, w modelu wykorzystującym model cenowy Calvo. Goodfriend i King zaproponowali listę czterech elementów, które są kluczowe dla nowej syntezy: optymalizacja międzyczasowa, racjonalne oczekiwania, niedoskonała konkurencja i kosztowna korekta cen (koszty menu). Goodfriend i King uważają również, że modele konsensusu wywołują pewne implikacje polityczne: podczas gdy polityka pieniężna może wpływać na rzeczywistą produkcję w krótkim okresie, ale nie ma kompromisu w długim okresie: pieniądze nie są neutralne w krótkim okresie, ale są w długim okresie. Inflacja ma negatywny wpływ na dobrobyt. Ważne jest, aby banki centralne utrzymywały wiarygodność dzięki polityce opartej na zasadach, takiej jak ukierunkowanie na inflację.

zasada Tayloraedytuj

w 1993 roku John B Taylor sformułował ideę reguły Taylora, która jest zredukowanym przybliżeniem reakcji nominalnej stopy procentowej, określonej przez bank centralny, na zmiany inflacji, produkcji lub inne warunki ekonomiczne. W szczególności zasada ta opisuje, w jaki sposób przy każdym jednoprocentowym wzroście inflacji bank centralny ma tendencję do podnoszenia nominalnej stopy procentowej o więcej niż jeden punkt procentowy. Ten aspekt reguły jest często nazywany zasadą Taylora. Chociaż takie zasady zapewniają zwięzłe, opisowe proxy dla polityki banku centralnego, w praktyce nie są one wyraźnie proskryptywnie brane pod uwagę przez banki centralne przy ustalaniu stóp nominalnych.

pierwotna wersja reguły Taylora opisuje, w jaki sposób nominalna stopa procentowa odpowiada odwrotności rzeczywistych stóp inflacji od docelowych stóp inflacji oraz rzeczywistego produktu krajowego brutto (PKB) od potencjalnego PKB:

i T = π T + R T ∗ + A π ( π t − π T ∗ ) + A y ( y t − y t ∗ ) . {\displaystyle i_{t}=\pi _{t}+r_ {t}^{*}+a_ {\pi} (\pi _{t}- \ pi _{t}^{*})+a_{y}(y_{t}-y_ {t}^{*}).}

w tym równaniu i t {\displaystyle \, i_{t}\,}

jest docelową krótkoterminową nominalną stopą procentową (np. stopa funduszy federalnych w USA, stopa bazowa Banku Anglii w Wielkiej Brytanii), π t {\displaystyle \, \ pi _{t}\,}

jest stopą inflacji mierzoną deflatorem PKB, π t ∗ {\displaystyle \ pi _{t}^{*}}

jest pożądaną stopą inflacji, r t ∗ {\displaystyle r_{t}^{*}}

jest założoną równowagą rzeczywistej stopy procentowej, y t {\displaystyle \, y_{t}\,}

jest logarytmem realnego PKB, a y t ∗ {\displaystyle y_{t}^{*}}

jest logarytmem wyjścia potencjału, określonym przez trend liniowy.

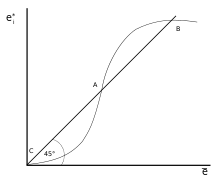

Nowy Keynesian Phillips curveEdit

nowy Keynesian Phillips curveedit został pierwotnie opracowany przez Robertsa w 1995 roku i od tego czasu jest używany w większości nowoczesnych modeli Keynesian DSGE. Nowa Krzywa Keynesa Phillipsa mówi, że inflacja tego okresu zależy od bieżącej produkcji i oczekiwań inflacji następnego okresu. Krzywa pochodzi z dynamicznego modelu Calvo wyceny i pod względem matematycznym jest:

π t = β E T + κ y t {\displaystyle \pi _{t}=\beta e_{t}+\kappa y_{t}}

bieżący okres t przewidywania inflacji następnego okresu są uwzględniane jako β e t {\displaystyle \ beta e_{t}}

, gdzie β {\displaystyle \beta }

jest czynnikiem rabatowym. Stała κ {\displaystyle \ kappa }

rejestruje reakcję inflacji na produkcję i jest w dużej mierze determinowana przez Prawdopodobieństwo zmiany ceny w dowolnym okresie, które wynosi h {\displaystyle h}

: κ = H 1-h γ {\displaystyle \kappa ={\frac {h}{1-h}}\gamma }

.

im mniej sztywne są ceny nominalne (tym wyższa jest h {\displaystyle h}

), tym większy wpływ produkcji na bieżącą inflację.

Nauka o polityce Pieniężnejedytuj

idee opracowane w latach 90. zostały zebrane w celu opracowania nowej keynesowskiej dynamicznej równowagi ogólnej stochastycznej stosowanej do analizy polityki pieniężnej. Ten kulminacyjny w The trzy równanie nowy Keynesian model znajdować w the badanie Richard Clarida, Jordi Gali, i Mark Gertler w The Journal of Economic Literature,. Łączy dwa równania nowej krzywej Keynesowskiego Phillipsa i reguły Taylora z krzywą dynamiczną is wyprowadzoną z równania optymalnego zużycia dynamicznego (równanie Eulera).

y t = y t + 1 + 1 σ ( i t − E T π T + 1 ) + v T {\displaystyle y_{t}=y_{t+1}+{\frac {1}{\sigma }}(i_{t}-E_{t}\pi _{t+1})+v_{t}}

te trzy równania stworzyły stosunkowo prosty model, który mógłby być wykorzystany do teoretycznej analizy zagadnień politycznych. Model ten został jednak w niektórych aspektach zbyt uproszczony (np. nie ma kapitału ani inwestycji). Ponadto, nie działa dobrze empirycznie.

2000sEdit

w nowym tysiącleciu nastąpił szereg postępów w Nowej Ekonomii keynesowskiej.

wprowadzenie niedoskonale konkurencyjnych rynkówedytuj

podczas gdy modele z Lat 90.skupiały się na lepkich cenach na rynku wyjściowym, w 2000 Christopher Erceg, Dale Henderson i Andrew Levin przyjęli model Blancharda i Kiyotaki unionizowanych rynków pracy, łącząc go z podejściem cenowym Calvo i wprowadzili go do nowego modelu Keynesian DSGE.

opracowanie złożonych modeli DSGE.Edit

aby mieć modele, które dobrze działały z danymi i mogły być używane do symulacji polityki, opracowano dość skomplikowane nowe modele Keynesowskie z kilkoma funkcjami. Prace naukowe zostały opublikowane przez Franka Smetsa i Rafaela Woutersa, a także Lawrence ’ a J. Christiano, Martina Eichenbauma i Charlesa Evansa.:

- wytrwałość nawyków. Użyteczność krańcowa konsumpcji zależy od konsumpcji w przeszłości.

- wycena Calvo zarówno na rynkach produkcji, jak i produktów, z indeksacją, tak aby gdy płace i ceny nie zostały wyraźnie zresetowane, były aktualizowane pod kątem inflacji.

- koszty dostosowania kapitału i zmienne wykorzystanie kapitału.

- nowe szoki

- szoki popytowe, które wpływają na krańcową użyteczność konsumpcji

- szoki marżowe, które wpływają na pożądaną marżę ceny w stosunku do kosztów krańcowych.

- politykę pieniężną reprezentuje reguła Taylora.

- metody szacowania Bayesa.

lepkie informacjeedit

idea lepkich informacji znalezionych w modelu Fischera została później rozwinięta przez Gregory ’ ego Mankiwa i Ricardo Reisa. To dodało nową funkcję do modelu Fischera: istnieje stałe prawdopodobieństwo, że w każdym okresie możesz zmienić swoje zarobki lub ceny. Korzystając z danych kwartalnych, zakładali wartość 25%: oznacza to, że w każdym kwartale 25% losowo wybranych firm/związków może zaplanować trajektorię bieżących i przyszłych cen w oparciu o bieżące informacje. Tak więc, jeśli weźmiemy pod uwagę bieżący okres: 25% cen będzie oparte na najnowszych dostępnych informacjach; reszta na podstawie informacji, które były dostępne, kiedy ostatni raz byli w stanie odtworzyć swoją trajektorię cenową. Mankiw i Reis stwierdzili, że model lepkiej informacji stanowi dobry sposób na Wyjaśnienie utrzymywania się inflacji.

modele informacji nie mają nominalnej sztywności: firmy lub związki zawodowe mają swobodę wyboru różnych cen lub płac dla każdego okresu. To informacje są lepkie, a nie Ceny. Tak więc, gdy firma ma szczęście i może ponownie zaplanować swoje obecne i przyszłe ceny, wybierze trajektorię tego, co uważa za optymalne ceny teraz i w przyszłości. Ogólnie rzecz biorąc, będzie to wiązało się z ustalaniem innej ceny w każdym okresie objętym planem. Jest to sprzeczne z empirycznymi dowodami na ceny. Obecnie istnieje wiele badań sztywności cen w różnych krajach: w Stanach Zjednoczonych, strefie euro, Wielkiej Brytanii i innych. Wszystkie te badania pokazują, że chociaż istnieją sektory, w których ceny często się zmieniają, istnieją również inne sektory, w których ceny pozostają stałe w czasie. Brak lepkich cen w modelu lepkiej informacji jest niezgodny z zachowaniem cen w większości gospodarki. Doprowadziło to do prób sformułowania modelu „podwójnej lepkości”, który łączy lepkie informacje z lepkimi cenami.

2010sEdit

w 2010 roku opracowano modele zawierające heterogeniczność gospodarstw domowych w standardowym New Keynesian framework, powszechnie określane jako modele „HANK” (czynnik heterogeniczny New Keynesian). Oprócz lepkich cen, typowy model Hanka charakteryzuje się nieuleczalnym idiosynkratycznym ryzykiem dochodów z pracy, co prowadzi do nie-zdegenerowanego podziału bogactwa. Najwcześniejsze modele z tymi dwoma funkcjami to Oh and Reis (2012), McKay and Reis (2016) oraz Guerrieri and Lorenzoni (2017).

nazwa „HANK model” została ukuta przez Grega Kaplana, Benjamina Molla i Gianluca Violante w artykule z 2018 roku, który dodatkowo modeluje gospodarstwa domowe jako gromadzące dwa rodzaje aktywów, jeden płynny, drugi niepłynny. Przekłada się to na bogatą heterogeniczność składu portfela w gospodarstwach domowych. W szczególności model ten pasuje do dowodów empirycznych, przedstawiając dużą część gospodarstw domowych posiadających niewielkie bogactwa płynne: gospodarstwa domowe „od ręki do ust”. Zgodnie z empirycznymi dowodami, około dwie trzecie tych gospodarstw domowych posiada nietrywialne ilości niepłynnego bogactwa, pomimo posiadania Niewielkiego bogactwa płynnego. Te gospodarstwa domowe są znane jako zamożne gospodarstwa domowe, termin wprowadzony w 2014 roku przez Kaplana i Violante w badaniu polityki bodźców fiskalnych.

istnienie bogatych gospodarstw domowych w nowych modelach Keynesowskich ma znaczenie dla efektów polityki pieniężnej, ponieważ zachowania konsumpcyjne tych gospodarstw domowych są silnie wrażliwe na zmiany dochodu rozporządzalnego, a nie wahania stóp procentowych (tj. Cena przyszłego zużycia w stosunku do bieżącego zużycia). Bezpośrednią konsekwencją jest to, że polityka pieniężna jest głównie przekazywana za pośrednictwem efektów równowagi ogólnej, które działają poprzez dochód z pracy w gospodarstwie domowym, a nie poprzez substytucję międzyczasową, która jest głównym kanałem transmisji w reprezentatywnych nowych modelach Keynesowskich (RANK).

istnieją dwa główne implikacje dla polityki pieniężnej. Po pierwsze, polityka pieniężna silnie współgra z polityką fiskalną, ze względu na brak równoważności Ricardian spowodowany obecnością gospodarstw domowych. W szczególności zmiany stóp procentowych zmieniają ograniczenia budżetowe rządu, a reakcja fiskalna na tę zmianę wpływa na dochody rozporządzalne gospodarstw domowych. Po drugie, zagregowane wstrząsy monetarne nie są neutralne pod względem dystrybucji, ponieważ wpływają na zwrot z kapitału, co w różny sposób wpływa na gospodarstwa domowe o różnym poziomie zamożności i aktywów.