- 1970sEdit

- 1980sEdit

- menus costs and Imperfect CompetitionEdit

- coordenação falha de coordenação

- falências no mercado de trabalho: aumento da eficiência

- 1990sEdit

- the new neoclassical synthesedit

- Taylor RuleEdit

- The New Keynesian Phillips curveEdit

- the Science of Monetary PolicyEdit

- 2000sEdit

- A introdução de imperfeições de trabalho competitiva marketsEdit

- o desenvolvimento de modelos dsge complexos.Edite

- Sticky informationEdit

- 2010sEdit

1970sEdit

the first wave of New Keynesian economics developed in the late 1970s. The first model of Sticky information was developed by Stanley Fischer in his 1977 article, Long-Term Contracts, Rational Expectations, and the Optimal Money Supply Rule. Ele adotou um modelo de contrato” escalonado “ou” sobreposto”. Suponha que existem dois sindicatos na economia, que se revezam para escolher salários. Quando é a vez de um sindicato, ele escolhe os salários que vai definir para os próximos dois períodos. Isto contrasta com John B. Modelo de Taylor onde o salário nominal é constante ao longo da vida contratual, como foi posteriormente desenvolvido em seus dois artigos, um em 1979 “fixação escalonada de salários em um modelo macro”. and one in 1980 “Aggregate Dynamics and Staggered Contracts”. Tanto os contratos de Taylor como de Fischer partilham a característica de que apenas os sindicatos que fixam o salário no período actual estão a utilizar as informações mais recentes: os salários em metade da economia ainda reflectem informações antigas. O modelo Taylor tinha salários nominais pegajosos, além da informação pegajosa: os salários nominais tinham de ser constantes durante a duração do contrato (dois períodos). Estas primeiras novas teorias keynesianas foram baseadas na ideia básica de que, dados os salários nominais fixos, uma autoridade monetária (banco central) pode controlar a taxa de emprego. Uma vez que os salários são fixados a uma taxa nominal, a autoridade monetária pode controlar o salário real (valores salariais ajustados para a inflação) alterando a oferta monetária e, assim, afectar a taxa de emprego.

1980sEdit

In the 1980s the key concept of Use menu costs in a framework of imperfect competition to explain price stickiness was developed. The concept of a lump-sum cost (menu cost) to changing the price was originally introduced by Sheshinski and Weiss (1977) in their paper looking at the effect of inflation on the frequency of price-changes. A ideia de aplicá-la como uma teoria geral da rigidez Nominal dos preços foi apresentada simultaneamente por vários economistas em 1985-6. George Akerlof e Janet Yellen apresentaram a ideia de que, devido à racionalidade limitada empresas não vai querer mudar o seu preço a menos que o benefício é mais do que uma pequena quantidade. Esta racionalidade limitada conduz à inércia dos preços nominais e dos salários, o que pode levar à flutuação da produção a preços e salários nominais constantes. Gregory Mankiw pegou a ideia de menu-custo e focou-se nos efeitos de bem-estar das mudanças na produção resultantes de preços pegajosos. Michael Parkin também apresentou a ideia. Embora a abordagem inicialmente focada principalmente na rigidez dos preços nominais, foi estendida aos salários e preços por Olivier Blanchard e Nobuhiro Kiyotaki em seu artigo influente concorrência monopolista e os efeitos da demanda agregada . Huw Dixon e Claus Hansen mostraram que mesmo que os custos do menu fossem aplicados a um pequeno setor da economia, isso influenciaria o resto da economia e levaria a que os preços no resto da economia se tornassem menos sensíveis às mudanças na demanda.Embora alguns estudos sugiram que os custos do menu são muito pequenos para ter muito impacto agregado, Laurence Ball e David Romer mostraram em 1990 que a rigidez real poderia interagir com a rigidez nominal para criar desequilíbrio significativo. A rigidez real ocorre sempre que uma empresa é lenta a ajustar os seus preços reais em resposta a uma conjuntura económica em mudança. Por exemplo, uma empresa pode enfrentar uma rigidez real se tiver poder de mercado ou se os seus custos de inputs e salários estiverem bloqueados por um contrato. Ball e Romer argumentaram que a rigidez real no mercado de trabalho mantém altos os custos de uma empresa, o que faz com que as empresas hesitem em cortar os preços e perder a receita. A despesa criada pela rigidities real combinada com o custo do menu de mudar os preços faz com que seja menos provável que a empresa reduza os preços a um nível de compensação do mercado.Mesmo que os preços sejam perfeitamente flexíveis, a concorrência imperfeita pode afectar a influência da política fiscal em termos de multiplicador. Huw Dixon e Gregory Mankiw desenvolveram de forma independente modelos gerais de equilíbrio simples, mostrando que o Multiplicador fiscal poderia estar aumentando com o grau de concorrência imperfeita no mercado de produção. A razão para isso é que a concorrência imperfeita no mercado de produção tende a reduzir o salário real, levando a família a substituir o consumo pelo lazer. Quando a despesa pública é aumentada, o aumento correspondente da tributação de montante fixo faz com que tanto o lazer como o consumo diminuam (assumindo que ambos são um bem normal). Quanto maior for o grau de concorrência imperfeita no mercado da produção, menor será o salário real e, por conseguinte, mais a redução recai sobre os tempos livres (isto é, as famílias trabalham mais) e menos sobre o consumo. Por conseguinte, o Multiplicador fiscal é inferior a um, mas aumenta o grau de concorrência imperfeita no mercado da produção.Em 1983, Guillermo Calvo escreveu “preços escalonados em um quadro de maximização de utilidade”. O artigo original foi escrito em uma estrutura matemática de tempo contínuo, mas hoje em dia é usado principalmente em sua versão de tempo discreto. O modelo Calvo tornou-se a forma mais comum de modelar a rigidez nominal em novos modelos keynesianos. Há uma probabilidade de que a empresa pode redefinir seu preço em qualquer período h (a taxa de perigo), ou equivalentemente a probabilidade (1-h) de que o preço permanecerá inalterado nesse período (A taxa de sobrevivência). A probabilidade h é às vezes chamada de “probabilidade Calvo” neste contexto. No modelo Calvo, a característica crucial é que o fixador de preços não sabe quanto tempo o preço nominal permanecerá em vigor, em contraste com o modelo Taylor, onde a duração do contrato é conhecida ex ante.

coordenação falha de coordenação

o fracasso da coordenação foi outro importante novo conceito keynesiano desenvolvido como outra explicação potencial para recessões e desemprego. Nas recessões uma fábrica pode ir ocioso mesmo que haja pessoas dispostas a trabalhar nela, e pessoas dispostas a comprar a sua produção se tivessem empregos. Em tal cenário, as quedas econômicas parecem ser o resultado do fracasso da coordenação: a mão invisível não consegue coordenar o fluxo usual, ideal, de produção e consumo. Russell Cooper e André João de 1988, o papel de Coordenação de Falhas de Coordenação em Modelos Keynesianos expressa uma forma geral de coordenação, como os modelos com múltiplos equilíbrios, onde agentes podem coordenar-se para melhorar (ou pelo menos não prejudicar a) cada uma das suas respectivas situações. Cooper e John basearam seus trabalhos em modelos anteriores, incluindo o modelo de coco de 1982 de Peter Diamond, que demonstrou um caso de falha de coordenação envolvendo pesquisa e teoria de correspondência. No modelo da Diamond, os produtores são mais propensos a produzir se virem outros produzindo. O aumento de possíveis parceiros comerciais aumenta a probabilidade de um determinado produtor encontrar alguém com quem negociar. Como em outros casos de falha de coordenação, o modelo de Diamond tem múltiplos equilíbrios, e o bem-estar de um agente depende das decisões de outros. O modelo de Diamond é um exemplo de uma” externalidade de mercado grosso ” que faz com que os mercados funcionem melhor quando mais pessoas e empresas participam neles. Outras fontes potenciais de falha de coordenação incluem profecias auto-realizáveis. Se uma empresa antecipa uma queda na demanda, eles podem cortar na contratação. A falta de vagas de emprego pode preocupar os trabalhadores que, em seguida, reduzir o seu consumo. Esta queda na demanda atende às expectativas da empresa, mas é inteiramente devido às próprias ações da empresa.

falências no mercado de trabalho: aumento da eficiência

novos keynesianos ofereceram explicações para o fracasso do mercado de trabalho para limpar. Em um mercado Walrasiano, os trabalhadores desempregados licitam salários baixos até que a demanda por trabalhadores atende a oferta. Se os mercados são Walrasian, as fileiras dos desempregados seriam limitadas aos trabalhadores que transitam entre o emprego e os trabalhadores que optam por não trabalhar porque os salários são demasiado baixos para atraí-los. Eles desenvolveram várias teorias explicando por que os mercados poderiam deixar trabalhadores dispostos desempregados. A mais importante destas teorias, os novos keynesianos foi a teoria da eficiência salarial usada para explicar os efeitos a longo prazo do desemprego anterior, onde os aumentos a curto prazo do desemprego tornam-se permanentes e levam a níveis mais elevados de desemprego a longo prazo.

em modelos de salários de eficiência, os trabalhadores são pagos em níveis que maximizam a produtividade em vez de limpar o mercado. Por exemplo, nos países em desenvolvimento, as empresas podem pagar mais do que uma taxa de mercado para garantir que os seus trabalhadores podem dar ao luxo de nutrição suficiente para ser produtivo. As empresas também podem pagar salários mais elevados para aumentar a lealdade e moral, possivelmente levando a uma melhor produtividade. As empresas também podem pagar mais do que os salários de mercado para evitar a evasão. Modelos de esquivamento foram particularmente influentes.O trabalho de Carl Shapiro e Joseph Stiglitz de 1984 equilibram o desemprego como um dispositivo de Disciplina dos trabalhadores criou um modelo onde os empregados tendem a evitar o trabalho a menos que as empresas possam monitorar o esforço dos trabalhadores e ameaçar os trabalhadores com desemprego. Se a economia está em pleno emprego, um shirker demitido simplesmente se muda para um novo emprego. As empresas pagam aos seus trabalhadores um prémio superior à taxa do mercado para garantir que os seus trabalhadores preferem trabalhar e manter o seu emprego actual em vez de se esquivarem e correrem o risco de terem de mudar para um novo emprego. Uma vez que cada empresa paga mais do que os salários de compensação do mercado, o mercado de trabalho agregado não consegue limpar. Isso cria um pool de trabalhadores desempregados e acrescenta à despesa de ser demitido. Os trabalhadores não só arriscam um salário mais baixo, como correm o risco de ficar presos na piscina dos desempregados. Manter os salários acima dos níveis de compensação do mercado cria um sério desincentivo a esquivar-se, o que torna os trabalhadores mais eficientes, embora deixe alguns trabalhadores dispostos a ficar desempregados.

1990sEdit

the new neoclassical synthesedit

In the early 1990s, economists began to combine the elements of new Keynesian economics developed in the 1980s and earlier with Real Business Cycle Theory. Os modelos RBC eram dinâmicos, mas assumiam uma competição perfeita; os novos modelos keynesianos eram primariamente estáticos, mas baseados na concorrência imperfeita. A nova síntese neoclássica essencialmente combinou os aspectos dinâmicos da RBC com competição imperfeita e rigidez nominal de novos modelos keynesianos. Tack Yun foi um dos primeiros a fazer isso, em um modelo que usou o modelo de preços Calvo. Goodfriend e King propuseram uma lista de quatro elementos que são centrais para a nova síntese: otimização intertemporal, expectativas racionais, concorrência imperfeita e custoso ajuste de preço (custos do menu). Goodfriend e King também que os modelos de consenso produzir certas implicações de política: enquanto a política monetária pode afetar o produto real, a curto prazo, mas não há longo prazo trade-off: dinheiro não é neutra no curto prazo, mas é a longo prazo. A inflação tem efeitos negativos sobre o bem-estar. É importante que os bancos centrais mantenham a credibilidade através de uma política baseada em regras, como a fixação de objectivos para a inflação.

Taylor RuleEdit

Em 1993, João B Taylor formulou a idéia de uma regra de Taylor, que é uma forma reduzida de aproximação da capacidade de resposta da taxa nominal de juros, definida pelo banco central, a alterações na inflação, de saída, ou de outras condições económicas. Em particular, a regra descreve como, para cada aumento de um por cento na inflação, o Banco central tende a aumentar a taxa de juro nominal em mais de um ponto percentual. Este aspecto da regra é muitas vezes chamado de princípio de Taylor. Embora tais regras proporcionem proxies concisos e descritivos para a política dos bancos centrais, não são, na prática, explicitamente considerados de forma proscritiva pelos bancos centrais ao estabelecerem as taxas nominais.

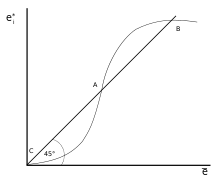

Taylor versão original da regra descreve como a taxa de juro nominal responde todivergences de reais taxas de inflação a partir de destino taxas de inflação e de real do Produto Interno Bruto (PIB) do PIB potencial:

i t = π t + r t ∗ + a π ( π t − π t ∗ ) + y ( y t − y t ∗ ) . {\displaystyle i_{t}=\pi _{t}+r_{t}^{*}+a_{\pi }(\pi _{t}-\pi _{t}^{*})+a_{y}(y_{t}-y_{t}^{*}).}

nesta equação, i t {\displaystyle \, i_ {t}\,}

é a taxa de juro nominal de curto prazo (e.g. a taxa dos fundos federais NOS eua, o Banco da Inglaterra taxa base no reino UNIDO), π t {\displaystyle \,\pi _{t}\,}

é a taxa de inflação, medida pelo deflator do PIB, π t ∗ {\displaystyle \pi _{t}^{*}}

é o desejado, a taxa de inflação, o r t ∗ {\displaystyle r_{t}^{*}}

é o assumido real de equilíbrio da taxa de juros, y t {\displaystyle \,y_{t}\,}

é o logaritmo do PIB real, e y t ∗ {\displaystyle y_{t}^{*}}

é o logaritmo da saída potencial, determinado por uma tendência linear.

The New Keynesian Phillips curveEdit

The New Keynesian Phillips curve was originally derived by Roberts in 1995, and has since been used in most state-of-the-art New Keynesian DSGE models. A nova curva de Phillips keynesiana diz que a inflação deste período Depende da produção atual e das expectativas da inflação do próximo período. A curva é derivada do modelo Calvo dinâmico de preços e em termos matemáticos é:

π t = β t + κ y t {\displaystyle \pi _{t}=\beta E_{t}+\kappa y_{t}}

O período atual t expectativas do próximo período de inflação são incorporados como β E t {\displaystyle \beta E_{t}}

, onde β {\displaystyle \beta }

é o factor de desconto. A constante κ {\displaystyle \kappa }

captura a resposta da inflação para a saída, e é em grande parte determinada pela probabilidade de alteração de preço, em qualquer período, que é h {\displaystyle h}

: κ = h 1 − h γ {\displaystyle \kappa ={\frac {h}{1-h}}\gamma }

. Os preços nominais menos rígidos são os mais elevados.}

), quanto maior for o efeito do produto sobre a inflação actual.

the Science of Monetary PolicyEdit

The ideas developed in the 1990s were Pound to develop the new Keynesian Dynamic stochastic general equilibrium used to analyse monetary policy. Isto culminou na equação de três novos modelos keynesianos encontrados na pesquisa de Richard Clarida, Jordi Gali e Mark Gertler no Journal of Economic Literature,. Ele combina as duas equações da nova curva de Phillips keynesiana e a regra de Taylor com a dinâmica é a curva derivada da equação de consumo dinâmico ideal (equação de Euler de household).

y t = y t + 1 + 1 σ ( i t − E t π t + 1 ) + v t {\displaystyle y_{t}=y_{t+1}+{\frac {1}{\sigma }}(i_{t}-E_{t}\pi _{t+1})+v_{t}}

Estas três equações formado um modelo relativamente simples que poderia ser usada para a análise teórica das questões de política. No entanto, o modelo foi simplificado em alguns aspectos (por exemplo, não há capital ou investimento). Além disso, não tem um bom desempenho empiricamente.

2000sEdit

In The new millennium there have been several advances in new Keynesian economics.

A introdução de imperfeições de trabalho competitiva marketsEdit

Enquanto os modelos da década de 1990, focado em preços viscosos na saída do mercado, em 2000, Christopher Erceg, Dale Henderson e Andrew Levin adotou a Blanchard e Kiyotaki modelo de sindicalizados mercados de trabalho, combinando-as com o Calvo preços abordagem e a introduziu em um novo Keynesiano, modelo DSGE.

o desenvolvimento de modelos dsge complexos.Edite

a fim de ter modelos que funcionassem bem com os dados e pudessem ser usados para simulações de políticas, novos modelos keynesianos bastante complicados foram desenvolvidos com várias características. Artigos seminais foram publicados por Frank Smets e Rafael Wouters e também Lawrence J. Christiano, Martin Eichenbaum e Charles Evans.:

- persistência do hábito. A utilidade marginal do consumo depende do consumo passado.

- Calvo preços tanto na produção como nos mercados de produtos, com indexação de modo que, quando os salários e os preços não são explicitamente redefinidos, eles são atualizados para a inflação.

- custos de ajustamento do capital e utilização do capital variável.

- novos choques

- procura choques que afetam a utilidade marginal do consumo

- marcação choques que influenciam o desejado de marcação do preço sobre o custo marginal.

- a política monetária é representada por uma regra Taylor.

- Métodos de estimativa Bayesiana.

Sticky informationEdit

a ideia de informação pegajosa encontrada no modelo de Fischer foi mais tarde desenvolvida por Gregory Mankiw e Ricardo Reis. Isto adicionou uma nova característica ao modelo de Fischer: há uma probabilidade fixa de que você pode rever seus salários ou preços a cada período. Usando dados trimestrais, eles assumiram um valor de 25%: ou seja, cada trimestre 25% das empresas/sindicatos escolhidos aleatoriamente podem planejar uma trajetória de preços atuais e futuros com base na informação atual. Assim, se considerarmos o período atual: 25% dos preços serão baseados nas últimas informações disponíveis; o resto da informação que estava disponível quando eles foram capazes de rever sua trajetória de preços. Mankiw e Reis descobriram que o modelo de informação pegajosa forneceu uma boa maneira de explicar a persistência da inflação.Os modelos de informação pegajosa não têm rigidez nominal: as empresas ou os sindicatos são livres de escolher preços ou salários diferentes para cada período. É a informação que é pegajosa, não os preços. Assim, quando uma empresa tem sorte e pode re-planejar seus preços atuais e futuros, ela escolherá uma trajetória do que acredita que serão os preços ótimos agora e no futuro. Em geral, tal implicará a fixação de um preço diferente em cada período abrangido pelo plano. Isto está em desacordo com a evidência empírica sobre os preços. Existem agora muitos estudos sobre a rigidez dos preços em diferentes países: os Estados Unidos, a zona euro, o Reino Unido e outros. Todos estes estudos mostram que, embora existam alguns sectores em que os preços mudam frequentemente, existem também outros sectores em que os preços permanecem fixos ao longo do tempo. A falta de preços pegajosos no modelo de informação pegajosa é inconsistente com o comportamento dos preços na maioria da economia. Isto levou a tentativas de formular um modelo de “Dual stickiness” que combina informação pegajosa com preços pegajosos.

2010sEdit

the 2010s saw the development of models incorporating household heterogeneity into the standard New Keynesian framework, commonly referred as `HANK’ models (Heterogeneous Agent New Keynesian). Além de preços pegajosos, um modelo HANK típico apresenta um risco idiossincrático de renda do trabalho que dá origem a uma distribuição de riqueza não degenerada. Os primeiros modelos com estas duas características incluem Oh e Reis (2012), McKay e Reis (2016) e Guerrieri e Lorenzoni (2017).

o nome “modelo HANK” foi cunhado por Greg Kaplan, Benjamin Moll e Gianluca Violante em um artigo de 2018 que adicionalmente modela as famílias como acumulando dois tipos de ativos, um líquido o outro ilíquido. Isto traduz-se numa grande heterogeneidade na composição da carteira entre as famílias. Em particular, o modelo encaixa-se em provas empíricas, apresentando uma grande parte das famílias com pouca riqueza líquida: as famílias “mão-a-boca”. Consistente com evidências empíricas, cerca de dois terços destas famílias possuem quantidades não triviais de riqueza ilíquida, apesar de possuírem pouca riqueza líquida. Estas famílias são conhecidas como ricas famílias de mão-a-boca, um termo introduzido em um estudo de 2014 das políticas de estímulo fiscal por Kaplan e Violante.A existência de famílias abastadas de mão-de-obra em novos modelos keynesianos importa para os efeitos da política monetária, porque o comportamento de consumo dessas famílias é fortemente sensível a variações no rendimento disponível, em vez de variações na taxa de juro (i.e. o preço do consumo futuro em relação ao consumo corrente). O corolário direto é que a política monetária é transmitida principalmente através de efeitos de equilíbrio geral que funcionam através da renda do trabalho doméstico, ao invés de através de substituição intertemporal, que é o principal canal de transmissão em modelos representativos do agente New Keynesian (RANK).

existem duas implicações principais para a política monetária. Em primeiro lugar, a política monetária interage fortemente com a política orçamental, devido ao fracasso da equivalência ricardiana devido à presença de famílias de mão-de-obra. Em particular, as alterações na taxa de juro alteram a restrição orçamental do Governo e a resposta orçamental a esta mudança afecta o rendimento disponível das famílias. Em segundo lugar, os choques monetários agregados não são neutros em termos de Distribuição, uma vez que afectam de forma diferente a rendibilidade do capital, que afecta as famílias com diferentes níveis de riqueza e activos.